Name

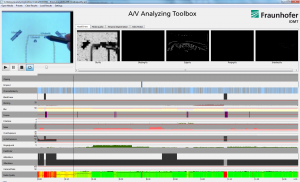

Musikanteilsmessung

Funktionsweise

Mit dem Algorithmus zur automatischen Musikanteilsmessung bietet das Fraunhofer IDMT eine effektive Lösung zur exakten Aufzeichnung von Musik- und Sprachanteilen zur Optimierung von Radio- und TV-Programmen und zur gerechten Abrechnung für Rechteverwerter und Anbieter.

Arbeits- und Zeitersparnis

Dank des neuen Fraunhofer-Softwaretools ist eine manuelle Ermittlung von Musikanteilen nicht mehr notwendig. Arbeits- und zeitintensive Auswertungen von Inhalts- und Programmlisten gehören somit der Vergangenheit an. Die trainierten und typischen Audiokategorien wie Musik, Sprache (Wortbeiträge), Musik und Sprache sowie Stille werden automatisch im Sendungsverlauf oder innerhalb einer Datei zeitlich ermittelt.

Hohe Genauigkeit

Je nach Einsatzgebiet oder konkreter Verwendung kann ein Erkennungsraster zwischen mehreren Sekunden und 100 Millisekunden gewählt werden, um z. B. statistische Normalisierungen auszunutzen.

Einfache Integration

Die automatische Musikanteilsmessung setzt auf eine skalierbare Integration in Standard-Workflows und Komponenten. Das System ist für den Einsatz in der Produktion, im Live-Betrieb sowie bei Aufzeichnungen – online wie offline – geeignet.

Unkomplizierter Export

Das Softwaremodul kann in vorhandene Content-Management-Systeme integriert werden. Dabei erfolgt die Datenausgabe wahlweise in XML-Dateien, CUE-Sheets oder anderen standardisierten Exportformaten.

Nutzungspotentiale und Einsatzgebiete

- Reporting: zertifizierte Musikanteilsmessung für Verwertungsgesellschaften

- Monitoring: Optimierung der Musikanteile von Programmen und Beiträgen

- Copyright: Filterung von Musikanteilen vor einer ressourcen-intensiven Abfrage von Titelinfos

Referenzprojekte

- BR, HR, NDR Musikanteilsmessung

Anbieter und Ansprechpartner

- Fraunhofer IDMT (http://www.idmt.fraunhofer.de/m2d) – Steffen Holly (Telefon: +49 3677 467 – 190, sholly@idmt.fraunhofer.de )